Szükségünk van olyan terminológiákra, mint az epochs, batch size, iterations, ha az adatok túl nagyok, ami a gépi tanulás során minden alkalommal megtörténik, és nem tudjuk egyszerre átadni az összes adatot a számítógépnek. Ennek a problémának a leküzdéséhez az adatokat kisebb méretűre kell osztanunk, és egyenként meg kell adnunk a számítógépünknek, és minden lépés végén frissítenünk kell a neurális hálózatok súlyát, hogy illeszkedjenek az adott adatokhoz.

Egy EPOCH: Amikor az egész adathalmaz oda-vissza keresztülmegy a neurális hálón csak egyszer.

Miért használunk több, mint egy epoch-ot?

A teljes adathalmaz egyszeri átadása nem elegendő, többször át kell adnunk ugyanannak a neurális hálónak.

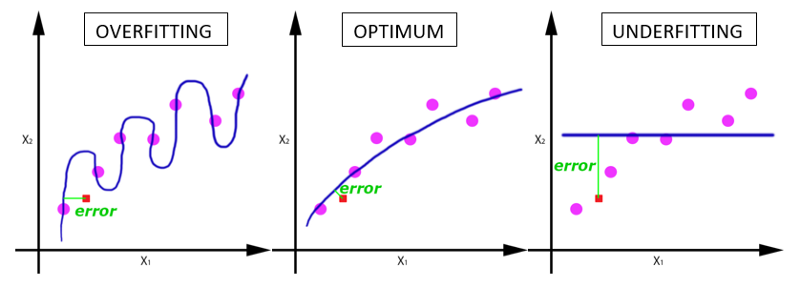

Egy epoch használata vezet az overfitting ellentétjéhez az underfitting-hez:

Ahogy az epoch-ok száma növekszik, többször változik a súly a neurális hálózatban, úgy a görbe az underfitting-ről az optimális görbe felé változik.

Mi a megfelelő epoch szám?

Erre a kérdésre nincs megfelelő válasz. A válasz különböző a különböző adatkészletek esetében, de azt mondhatjuk, hogy az epoch-ok száma arra utal, hogy az adatok mennyire változatosak. Pl.: Csak fekete macskák vannak az adathalmazban, vagy sokkal sokszínűbb?

BATCH SIZE: Az összes tanítási példa száma egy batch (tétel) során. A batch mérete (batch size) és a batch-ek száma (number of batches) két különböző dolog. Az egész adathalmazt nem tudjuk egyszerre átadni a neurális hálónak, ezért az adathalmazt felosztjuk a batch-ekre.

ITERATIONS: Az szükséges batch-ek száma egy epoch befejezéséhez. A batch-ek száma megegyezik az iterációk számával egy epoch során.

Példa: Mondjuk van 2000 tanítási példánk, amit használni fogunk. Fel tudjuk osztani a 2000 példás adathalmazt 500 batch-re, ez 4 iterációt vesz igénybe egy epoch befejezéséhez. Ahol a batch mérete 500, az iterációk száma 4 és az epoch pedig 1.

Forrás:https://towardsdatascience.com/epoch-vs-iterations-vs-batch-size-4dfb9c7ce9c9